点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

点击 阅读原文 观看作者直播讲解回放!

团队:认知智能全国重点实验室陈恩红团队,华为诺亚方舟实验室

论文链接: https://arxiv.org/pdf/2407.06645

代码链接: https://github.com/USTC-StarTeam/DR4SR

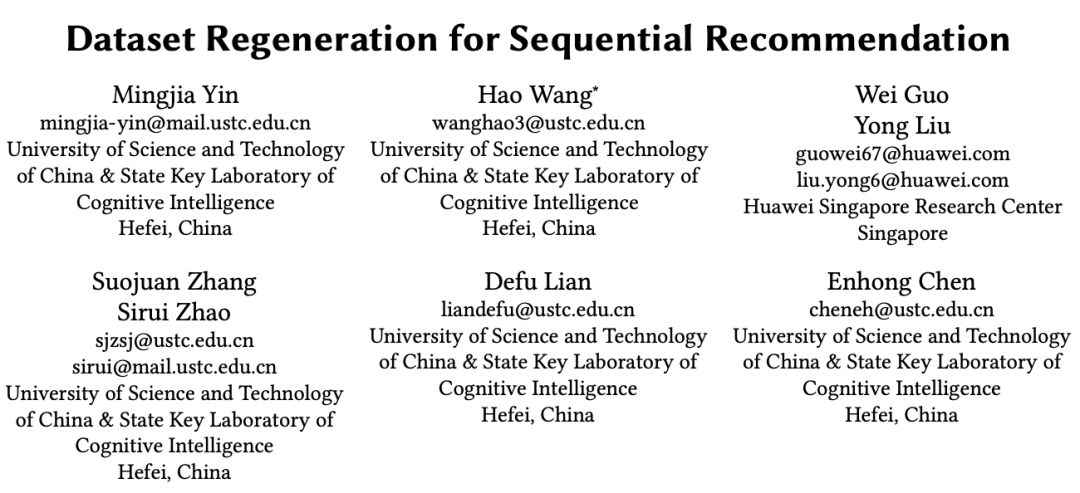

8 月 25 日 - 29 日在西班牙巴塞罗那召开的第 30 届 ACM 知识发现与数据挖掘大会 (KDD2024) 上,中国科学技术大学认知智能全国重点实验室陈恩红教授、IEEE Fellow,和华为诺亚联合发表的论文 “Dataset Regeneration for Sequential Recommendation”,获 2024 年大会 Research Track 唯一最佳学生论文奖。论文第一作者为中科大认知智能全国重点实验室陈恩红教授,连德富教授,与王皓特任副研究员共同指导的博士生尹铭佳同学,华为诺亚刘勇、郭威研究员也参与了论文的相关工作。这是自 KDD 于 2004 年设立该奖项以来,陈恩红教授团队的学生第二次荣获该奖项。

研究动机

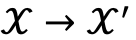

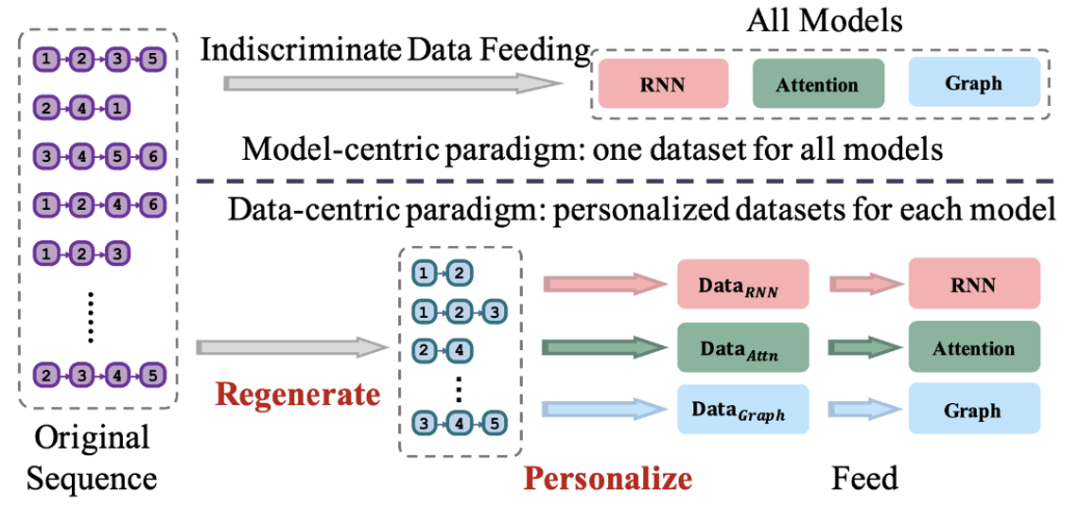

序列推荐系统(Sequential Recommender, SR)是现代推荐系统的重要组成部分,因为它旨在捕捉用户不断变化的偏好。近年来,研究者为了增强序列推荐系统的能力,已经付出了大量努力。这些方法通常遵循以模型为中心(Model-centric)的范式,即基于固定数据集开发有效的模型。然而,这种方法往往忽视了数据中潜在的质量问题和缺陷。为了解决这些问题,学界提出了以数据为中心(Data-centric)的范式,重点在于使用固定模型转而生成高质量的数据集。我们将其定义为 “数据集重生成” 问题。

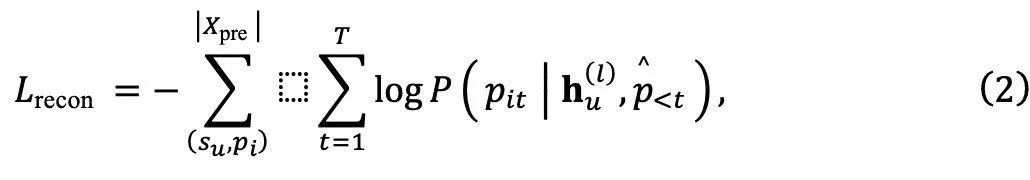

为了获得最佳的训练数据,研究团队的关键思路是学习一个显式包含物品转移模式的新数据集。具体来说,他们将推荐系统的建模过程分为两个阶段:从原始数据集中提取转移模式  ,并基于

,并基于  学习用户偏好

学习用户偏好 。由于学习从

。由于学习从  的映射涉及两个隐含的映射:

的映射涉及两个隐含的映射: ,因此这一过程具有挑战性。为此,研究团队探索了开发一个显式表示

,因此这一过程具有挑战性。为此,研究团队探索了开发一个显式表示 中的物品转移模式的数据集的可能性,这使得我们可以将学习过程明确地分为两个阶段,其中

中的物品转移模式的数据集的可能性,这使得我们可以将学习过程明确地分为两个阶段,其中  相对更容易学习。因此,他们的主要关注点是学习一个有效的

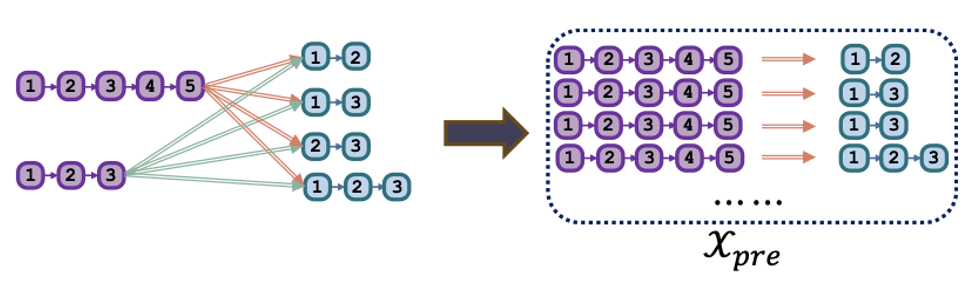

相对更容易学习。因此,他们的主要关注点是学习一个有效的 的映射函数,这是一个一对多的映射。研究团队将这一学习过程定义为数据集重生成范式,如图 1 所示,其中 “重生成” 意味着他们不引入任何额外信息,仅依赖原始数据集。

的映射函数,这是一个一对多的映射。研究团队将这一学习过程定义为数据集重生成范式,如图 1 所示,其中 “重生成” 意味着他们不引入任何额外信息,仅依赖原始数据集。

图1

为了实现数据集重生成,研究团队提出了一种新颖的以数据为中心的范式 —— 用于序列推荐的数据集重生成(DR4SR),旨在将原始数据集重生成一个信息丰富且具有通用性的数据集。具体来说,研究团队首先构建了一个预训练任务,使得数据集重生成成为可能。接着,他们提出了一种多样性增强的重生成器,以在重生成过程中建模序列和模式之间的一对多关系。最后,他们提出了一种混合推理策略,以在探索与利用之间取得平衡,生成新的数据集。

数据集重生成过程虽具通用性,但可能不完全适合特定目标模型。为解决这一问题,研究团队提出了 DR4SR+,这是一个模型感知的重生成过程,它根据目标模型的特性定制数据集。DR4SR + 通过双层优化问题和隐式微分技术,个性化评分并优化重生成数据集中的模式,以增强数据集效果。

研究方法

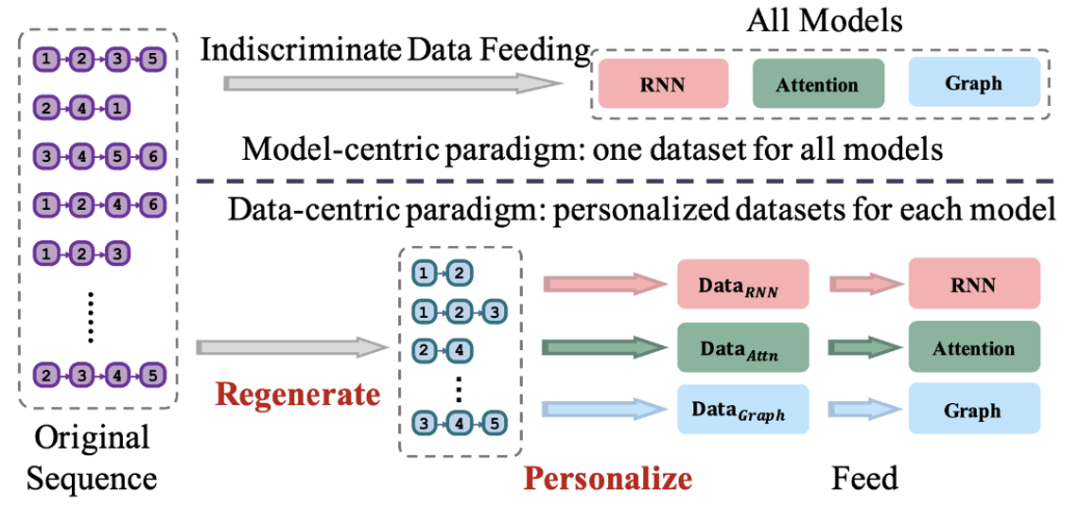

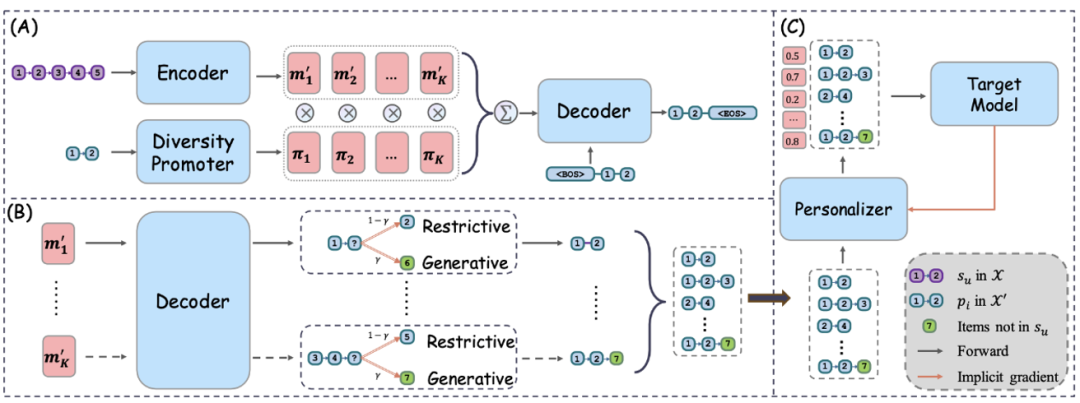

在本项研究中,研究团队提出了一个名为 “用于序列推荐的数据重生成”(DR4SR)的以数据为中心的框架,旨在将原始数据集重生成一个信息丰富且具有通用性的数据集,如图 2 所示。由于数据重生成过程是独立于目标模型的,因此重生成的数据集可能不一定符合目标模型的需求。因此,研究团队将 DR4SR 扩展为模型感知版本,即 DR4SR+,以针对特定的目标模型定制重生成的数据集。

模型无感知的数据集重生成

图2

为了开发一个信息丰富且具有通用性的数据集,研究团队旨在构建一个数据集重生成器,以促进数据集的自动重生成。然而,原始数据集中缺乏用于学习数据集重生成器的监督信息。因此,他们必须以自监督学习的方式来实现这一目标。为此,他们引入了一个预训练任务,以指导多样性增强重生成器的学习。在完成预训练后,研究团队进一步使用混合推理策略来重生成一个新数据集。

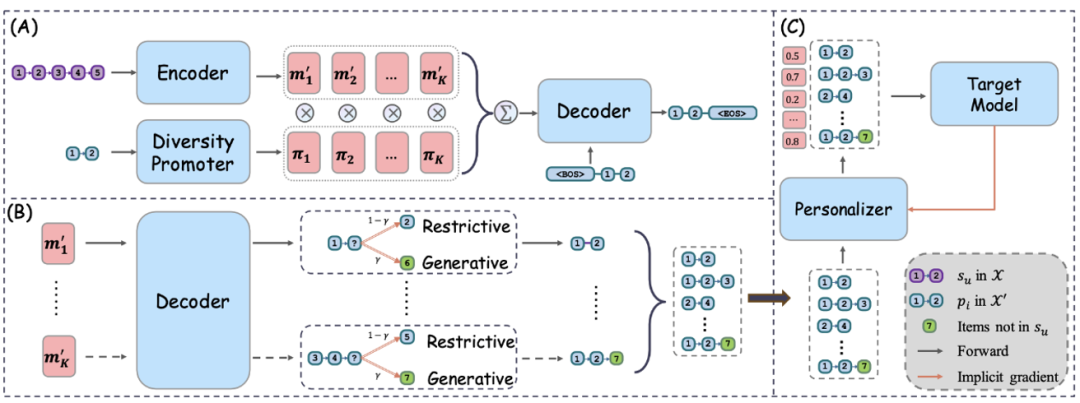

数据重生成预训练任务的构建:

图3

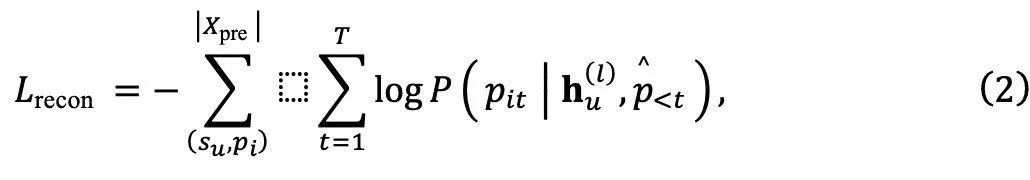

为了构建预训练任务,他们首先通过基于规则的方法获取物品转移模式。然后,要求重生成器  能够将

能够将  重生成对应的模式

重生成对应的模式  。研究团队将整个预训练数据集记作

。研究团队将整个预训练数据集记作

促进多样性的重生成器:

借助预训练任务,研究团队现在可以预训练一个数据集重生成器。本文中,他们采用 Transformer 模型作为重生成器的主要架构,其生成能力已被广泛验证。数据集重生成器由三个模块组成:一个用于获取原始数据集中序列表示的编码器、一个用于重生成模式的解码器,以及一个用于捕捉一对多映射关系的多样性增强模块。接下来,研究团队将分别介绍这些模块。

编码器由多个堆叠的多头自注意力(MHSA)和前馈网络(FFN)层组成。至于解码器,它将重生成数据集 X' 中的模式作为输入。解码器的目标是在给定编码器生成的序列表示的情况下重构模式

然而,从一个序列中可以提取多个模式,这在训练过程中会带来挑战。为了解决这一一对多映射问题,研究团队进一步提出了一个多样性增强模块。

具体而言,研究团队通过将目标模式的信息整合到解码阶段,来自适应地调节原始序列的影响。首先,他们将编码器生成的记忆  投影到 K 个不同的向量空间中,即

投影到 K 个不同的向量空间中,即  。理想情况下,不同的目标模式应与不同的记忆匹配。为此,他们还引入了一个 Transformer 编码器来编码目标模式并获取

。理想情况下,不同的目标模式应与不同的记忆匹配。为此,他们还引入了一个 Transformer 编码器来编码目标模式并获取  。他们将

。他们将  压缩成一个概率向量:

压缩成一个概率向量:

其中  ,

,  是选择第 k 个记忆的概率。为了确保每个记忆空间得到充分训练,我们不执行硬选择,而是通过加权求和得到最终的记忆:

是选择第 k 个记忆的概率。为了确保每个记忆空间得到充分训练,我们不执行硬选择,而是通过加权求和得到最终的记忆:

最终,可以利用获取的记忆来促进解码过程,并有效捕捉序列与模式之间复杂的一对多关系。

模型感知的数据集重生成

由于前面的重生成过程与目标模型无关,因此重生成的数据集可能对于特定的目标模型来说并不是最优的。因此,他们将模型无关的数据集重生成过程扩展为模型感知的重生成过程。为此,在数据集重生成器的基础上,他们引入了一个数据集个性化器,用于评估重生成数据集中每个数据样本的评分。然后,研究团队进一步通过隐式微分有效地优化数据集个性化器。

数据集个性化器:

研究团队的目标是训练一个参数为  的基于 MLP 实现的数据集个性化器

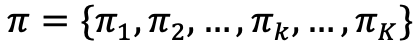

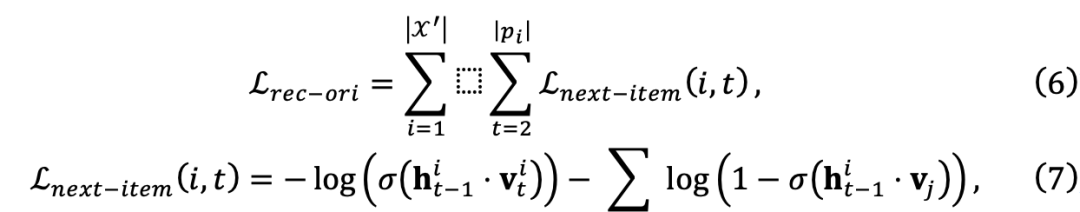

的基于 MLP 实现的数据集个性化器  ,用以评估每个数据样本 W 对于目标模型的评分。为了确保框架的通用性,研究团队利用计算得到的评分来调整训练损失的权重,这不需要对目标模型进行额外的修改。他们从定义原始的下一个物品预测损失开始:

,用以评估每个数据样本 W 对于目标模型的评分。为了确保框架的通用性,研究团队利用计算得到的评分来调整训练损失的权重,这不需要对目标模型进行额外的修改。他们从定义原始的下一个物品预测损失开始:

随后,个性化数据集的训练损失函数可以定义为:

实验结论

主要实验

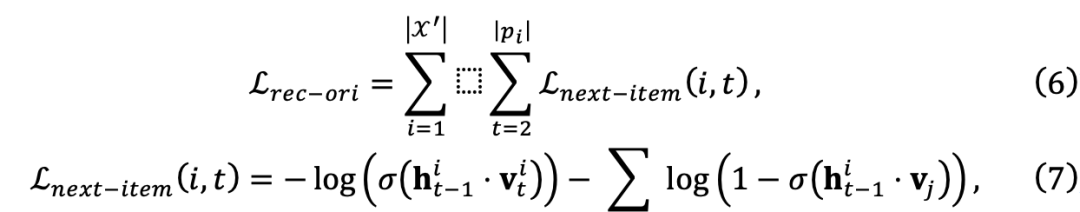

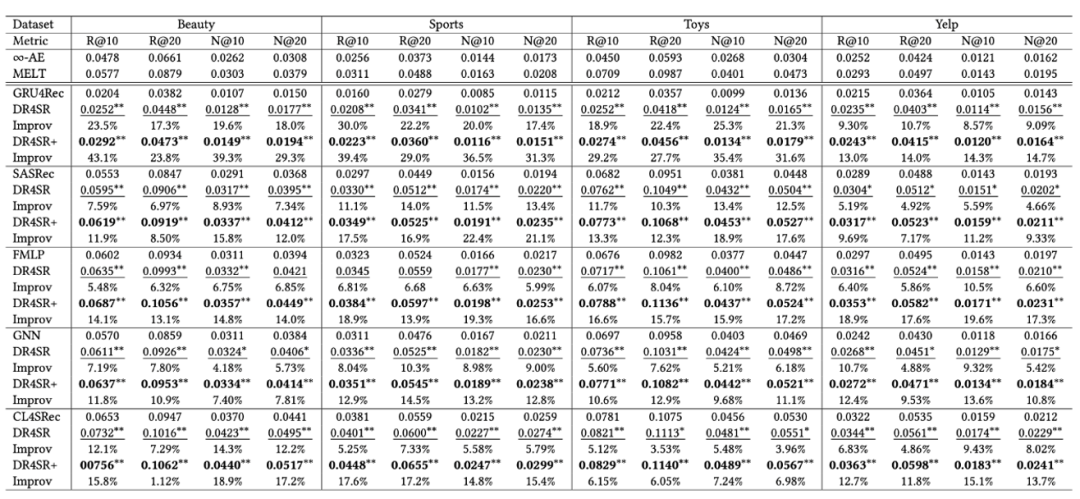

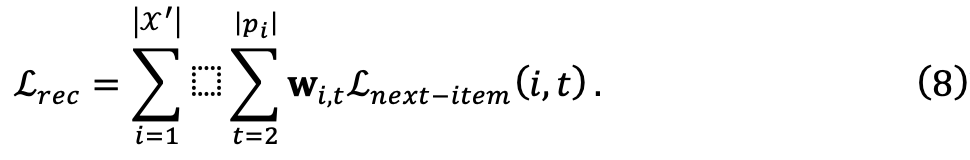

研究团队比较了每种目标模型与 “DR4SR” 和 “DR4SR+” 变体的性能,以验证所提出框架的有效性。

图4

从图 4 展示的整体性能中,可以得出以下结论:

点击 阅读原文 观看作者直播讲解回放!

往期精彩文章推荐

大咖分享 | 包云岗:处理器芯片的昨天、今天与明天 | 9月29日10:00

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了2000多位海内外讲者,举办了逾700场活动,超800万人次观看。

我知道你

在看

提出观点,表达想法,欢迎

留言

点击 阅读原文 观看作者直播讲解回放!

点击重新获取

点击重新获取

扫码支付

扫码支付

余额充值

余额充值

,并基于

,并基于  学习用户偏好

学习用户偏好 。由于学习从

。由于学习从  的映射涉及两个隐含的映射:

的映射涉及两个隐含的映射: ,因此这一过程具有挑战性。为此,研究团队探索了开发一个显式表示

,因此这一过程具有挑战性。为此,研究团队探索了开发一个显式表示 中的物品转移模式的数据集的可能性,这使得我们可以将学习过程明确地分为两个阶段,其中

中的物品转移模式的数据集的可能性,这使得我们可以将学习过程明确地分为两个阶段,其中  相对更容易学习。因此,他们的主要关注点是学习一个有效的

相对更容易学习。因此,他们的主要关注点是学习一个有效的 的映射函数,这是一个一对多的映射。研究团队将这一学习过程定义为数据集重生成范式,如图 1 所示,其中 “重生成” 意味着他们不引入任何额外信息,仅依赖原始数据集。

的映射函数,这是一个一对多的映射。研究团队将这一学习过程定义为数据集重生成范式,如图 1 所示,其中 “重生成” 意味着他们不引入任何额外信息,仅依赖原始数据集。

能够将

能够将  重生成对应的模式

重生成对应的模式  。研究团队将整个预训练数据集记作

。研究团队将整个预训练数据集记作

投影到 K 个不同的向量空间中,即

投影到 K 个不同的向量空间中,即  。理想情况下,不同的目标模式应与不同的记忆匹配。为此,他们还引入了一个 Transformer 编码器来编码目标模式并获取

。理想情况下,不同的目标模式应与不同的记忆匹配。为此,他们还引入了一个 Transformer 编码器来编码目标模式并获取  。他们将

。他们将  压缩成一个概率向量:

压缩成一个概率向量:

,

,  是选择第 k 个记忆的概率。为了确保每个记忆空间得到充分训练,我们不执行硬选择,而是通过加权求和得到最终的记忆:

是选择第 k 个记忆的概率。为了确保每个记忆空间得到充分训练,我们不执行硬选择,而是通过加权求和得到最终的记忆:

的基于 MLP 实现的数据集个性化器

的基于 MLP 实现的数据集个性化器  ,用以评估每个数据样本 W 对于目标模型的评分。为了确保框架的通用性,研究团队利用计算得到的评分来调整训练损失的权重,这不需要对目标模型进行额外的修改。他们从定义原始的下一个物品预测损失开始:

,用以评估每个数据样本 W 对于目标模型的评分。为了确保框架的通用性,研究团队利用计算得到的评分来调整训练损失的权重,这不需要对目标模型进行额外的修改。他们从定义原始的下一个物品预测损失开始:

490

490

蓝精灵801: 请问有实际效果吗

billythekids: 有论文名吗?

小何198: 您好,这个有具体的论文吗

小周_: 请问fashion200k是怎么测试的,它好像只有test query,那对应的测试三元组是怎么得到哈

小懒花苞: 这篇文章发表在哪里了呀